क्या आपने कभी देखा है कि अपनी साइट पर Robots.txt file कैसे जोड़ते है? कई लोग इससे अनजान हैं, वास्तव में आपका इस पर पूरा नियंत्रण होता है की किस पेज को सर्च रिजल्ट में दिखाना है और किस को नहीं दिखाना.

यदि आपने एक Blog बनाया है, तो आपको खोज इंजन में रैंक प्राप्त करने के लिए इस Robots.txt फ़ाइल को अपने ब्लॉग में जोड़ना होगा.

Robots.txt फ़ाइल क्या है? मैं आपको इसके बारे में बताने वाला हुं, क्या आप जानते हैं की ब्लॉगर में इसे Custom robots.txt file के रूप में जाना जाता है यानी आप इस फाइल को अपनी पसंद के हिसाब से कस्टमाइज कर सकते हैं.

आज के इस लेख में, हम इस पर गहराई से चर्चा करेंगे, मैं आपको यह भी बताऊंगा कि ब्लॉगर में एक Custom robots.txt file को कैसे जोड़ें.

रोबोट्स टेक्स्ट फाइल क्या है? (What is Robots.txt file in Hindi)

Robots.txt file को एक टेक्स्ट फाइल के रूप में जाना जाता है, जिसमें वेब क्रॉलर आपके ब्लॉग को खोज परिणामों में कैसे अनुक्रमित और क्रॉल करते हैं, इस पर निर्देश देते हुए, वेबसाइट या ब्लॉग के सर्वर पर सहेजे गए सरल कोड की कुछ पंक्तियाँ शामिल होती है.

रोबोट टेक्स्ट फ़ाइल आपको बेहतर ढंग से Define करने में मदद कर सकती है कि आप खोज बॉट को क्रॉल करना चाहते हैं या नहीं.

यह कई कारणों से भी उपयोगी है, जिसमें क्रॉल ट्रैफ़िक को नियंत्रित करना शामिल है ताकि यह सुनिश्चित किया जा सके कि क्रॉलर आपके सर्वर पर हावी न हो.

हमेशा याद रखें कि खोज क्रॉलर किसी वेब पेज को क्रॉल करने से पहले Robots.txt फ़ाइल को स्कैन करते हैं. सभी ब्लॉग की अपनी डिफ़ॉल्ट Robots.txt file होती है जो कुछ ऐसी दिखती है,

User-agent: *

Allow: /

Disallow:

Sitemap: http://www.webbloggertips.com/sitemap.xml

ब्लॉगर रोबोट्स टेक्स्ट फाइल का स्पष्टीकरण

1. User-agent: * यह सभी रोबोटों के लिए है जो इसतरह (*) के साथ चिह्नित है. इसका मतलब की सभी सर्च इंजन में शो कराना. यदि आपको गूगल सर्च इंजन पर अपने ब्लॉग पेज या पोस्ट यूआरएल इंस्ट्रक्ट देना है तो यही सर्च इंजन के बोट्स के नाम लिखे जाते है और सभी सर्च के बोट्स नाम अलग-अलग होते है, जैसे की User-agent: Googlebot इस तरह, ये बोट्स डेस्कटॉप और मोबाइल दोनों को रिप्रेजेंट करता है.

2. Allow: / Main page को Reference करता है जिसका मतलब है कि वेब क्रॉलर हमारे ब्लॉग के होमपेज को क्रॉल कर सकते हैं.

3. Disallow (for post): यह फाइलों और निर्देशिकाओं को अनुक्रमित होने से रोकता है. यहाँ उन पेज/पोस्ट को सर्च इंजन पर प्रतिबंध लगाने के लिए है जिनको हाईड करना चाहते है, डोमेन के बाद पोस्ट या पेज यूआरएल लिखा जाता है. नीचे इसका उदाहरण बताया है,

Disallow: /yyyy/mm/post-url.html

यहां yyyy और mm क्रमशः Post के प्रकाशन वर्ष और महीने का उल्लेख करते हैं, उदाहरण के लिए, यदि हमने मार्च 2016 में वर्ष 2016 में एक पोस्ट प्रकाशित किया है तो हमें ये फॉर्मेट का उपयोग करना होगा, जैसे इस तरह

Disallow: /2016/03/post-url.html

इस कार्य को आसान बनाने के लिए, आप बस पोस्ट URL को कॉपी कर सकते हैं और ब्लॉग का नाम शुरू से ही हटा सकते हैं. निम्न URL को search engine से हटाना चाहते हैं, तो यह इस तरह होगा

Disallow: /2018/02/how-create-blog-on-blogger.html

4. Disallow (for page): यदि हमें किसी पृष्ठ को अस्वीकार करने की आवश्यकता है तो हम उपरोक्त विधि के सेम उपयोग कर सकते हैं. बस पेज यूआरएल को कॉपी करें और ब्लॉग एड्रेस को हटा दें जो कुछ इस तरह दिखेगा,

Disallow: /p/knowledge-of-psychology.html

Sitemap: http://www.webbloggertips.com/sitemap.xml

यह कोड हमारे ब्लॉग के साइटमैप को संदर्भित करता है, यहां हम केवल साइटमैप लिंक जोड़कर अपने ब्लॉग के क्रॉलर दर को अनुकूलित कर सकते हैं.

जब भी वेब क्रॉलर हमारी robots.txt फ़ाइल को स्कैन करते हैं, तो वे हमारे साइटमैप पर अपना रास्ता पा सकते हैं जहां हमारे प्रकाशित पोस्ट के सभी लिंक मौजूद होते हैं.

वेब क्रॉलर हमारे सभी पोस्ट को क्रॉल करना आसान बनाते हैं। इसलिए वेब क्रॉलर किसी एक को अनदेखा किए बिना हमारे सभी ब्लॉग पोस्ट को क्रॉल करते है.

Sitemap: http://example.com/atom.xml?redirect=false&start-index=1&max-results=500

यदि आपके ब्लॉग पर 500 से अधिक प्रकाशित पोस्ट हैं, तो आप नीचे दिए गए दो साइटमैप का उपयोग कर सकते हैं.

=> Sitemap: http://example.com/atom.xml?redirect=false&start-index=1&max-results=500

=> Sitemap: http://example.com/atom.xml?redirect=false&start-index=501&max-results=1000

क्या मैं Blogger में कस्टम Robots.txt फ़ाइल का उपयोग कर सकता हूँ?

आप ब्लॉगर में एक कस्टम Robots.txt फ़ाइल का उपयोग कर सकते हैं, ब्लॉगर आपको इसे कुछ ही क्लिक के साथ बहुत आसानी से करने देगा.

लेकिन महत्वपूर्ण बात यह है कि यदि आप Robots.txt फ़ाइल के उपयोग को नहीं समझते हैं, तो आपको अपनी डिफ़ॉल्ट रोबोट टेक्स्ट फ़ाइल को जोड़ना और संपादित नहीं करना चाहिए.

क्योंकि आपके द्वारा बनाई गई आपकी Robots.txt फ़ाइल में त्रुटि के कारण, रोबोट तक पहुँचने और अनुक्रमणित करने से कई समस्याएं उत्पन्न होंगी.

इसलिए मेरा सुझाव है, यदि Robots.txt फ़ाइल को संपादित करने का कोई ठोस कारण नहीं है, तो आपको इसे डिफ़ॉल्ट के रूप में छोड़ देना चाहिए, ब्लॉगर मूल रूप से एक मानक Robots.txt फ़ाइल प्रदान करता है जो आपके लिए अच्छा काम करेगी.

ब्लॉगर में एक Custom Robots.txt फ़ाइल कैसे जोड़ते है?

सेल्फ होस्ट किए गए ब्लॉगों के लिए, हम आमतौर पर एक रोबोट्स टेक्स्ट फाइल बनाते हैं और इसे हमारे सर्वर की रूट डायरेक्टरी पर अपलोड किया जाता है. लेकिन ब्लॉगर डिफ़ॉल्ट रूप से एक robots.txt file को जोड़ना भी आसान बनाता है.

हम इस रोबोट टेक्स्ट फ़ाइल को अपनी इच्छानुसार संपादित कर सकते हैं, इसलिए यदि आप अपने ब्लॉगर ब्लॉग में रोबोट के लिए कुछ कस्टम robots.txt फ़ाइल जोड़ना चाहते हैं, तो नीचे दिए गए चरणों का पालन करें,

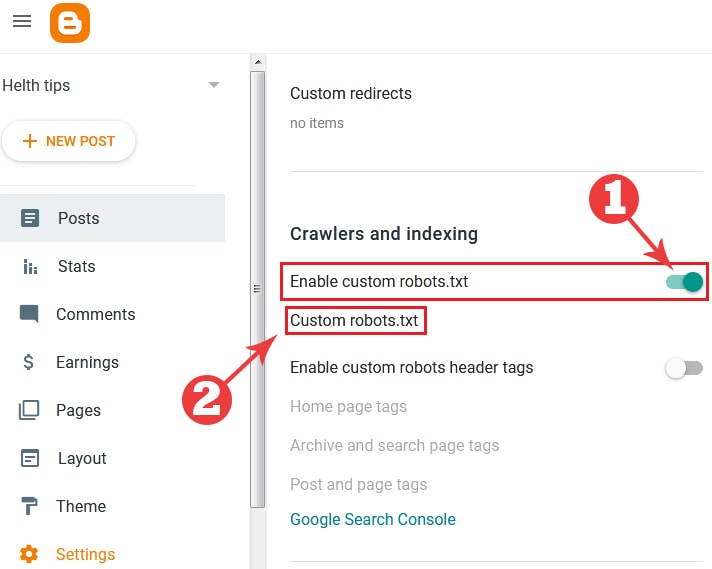

- सबसे पहले अपने ब्लॉग अकाउंट में लॉग इन करें.

- अपने ब्लॉग के ‘Settings‘ section पर जाएं

- ‘Crawlers and indexing’ अनुभाग मिल न जाये तब तक स्क्रॉल डाउन करते रहिये.

- ‘Enable custom robots.txt‘ के बगल में एक बटन दिया हुआ है इस पर क्लिक करके स्विच ऑन कर देना है.

- फिर इनके निचे ‘Custom robots.txt‘ पर क्लिक करे और नीचे दिए कोड Copy करके अपने कस्टम रोबोट्स टेक्स्ट बॉक्स में पेस्ट करे. एक बार पेस्ट करने के बाद ‘Save’ बटन पर क्लिक कर देना है.

User-agent: *

Allow: /

Sitemap: http://www.webbloggertps.com/sitemap.xml

अब आपकी Robots.txt फाइल जुड़ गई है.

अपनी रोबोट टेक्स्ट फ़ाइल की जांच कैसे करें?

क्या आप अपने ब्लॉग पर दिखाई देने वाली रोबोट फ़ाइल देखना चाहेंगे

वेब ब्राउजर में अपने ब्लॉग URL के अंत में आप /robots.txt को जोड़कर इस फाइल को अपने ब्लॉग पर देख सकते हैं, उदाहरण के लिए:

https://www.yourblogurl.com/robots.txt

एक बार जब आप Robots.txt file URL पर जाते हैं तो आपको पूरे कोड दिखाई देगा जो आपने कस्टम रोबोट्स टेक्स्ट file में उपयोग किया है.

इस तरह की प्रोसेस से अपने ब्लॉग में रोबोट्स टेक्स्ट फाइल को जोड़ सकते है.

आपने हमारा ब्लॉगर में Custom Robots.txt file को जोड़ने के लिए आज का पूरा लेख पढ़ा, मैंने इस लेख में जानकारी को सरल बनाने की पूरी कोशिश की है.

लेकिन फिर भी अगर आपका कोई सवाल है तो आप हमें कमेंट सेक्शन में पूछ सकते हैं और अज्ञात कोड को जाने बिना अपनी रोबोट टेक्स्ट फ़ाइल में कोई भी कोड न डालें.

आप एक नए ब्लॉगर पर ब्लॉग बनाये हैं, अभी आपने रोबोट फ़ाइल द्वारा ब्लॉगर ब्लॉग में इस लेख के माध्यम से कोड ऐड कर लिया है, साथ ही नीचे बताये गए लिंक पर जाएं जिसमें एक और काम बाकी है.

अगर आपको यह लेख पसंद आया हो तो कृपया इस पोस्ट को अपने सोशल मीडिया पर शेयर करना न भूलें.